一、什么是RAG?

RAG(Retrieval-Augmented Generation,检索增强生成)是一种结合检索(从外部知识库获取信息)和生成(基于检索结果生成回答)的技术,可以提升生成模型(如GPT)的准确性、时效性和可解释性。点此进入ChatWiki体验交流群,免费使用

它通过动态引入外部知识,弥补传统生成模型依赖静态训练数据、易产生“幻觉”的缺陷。

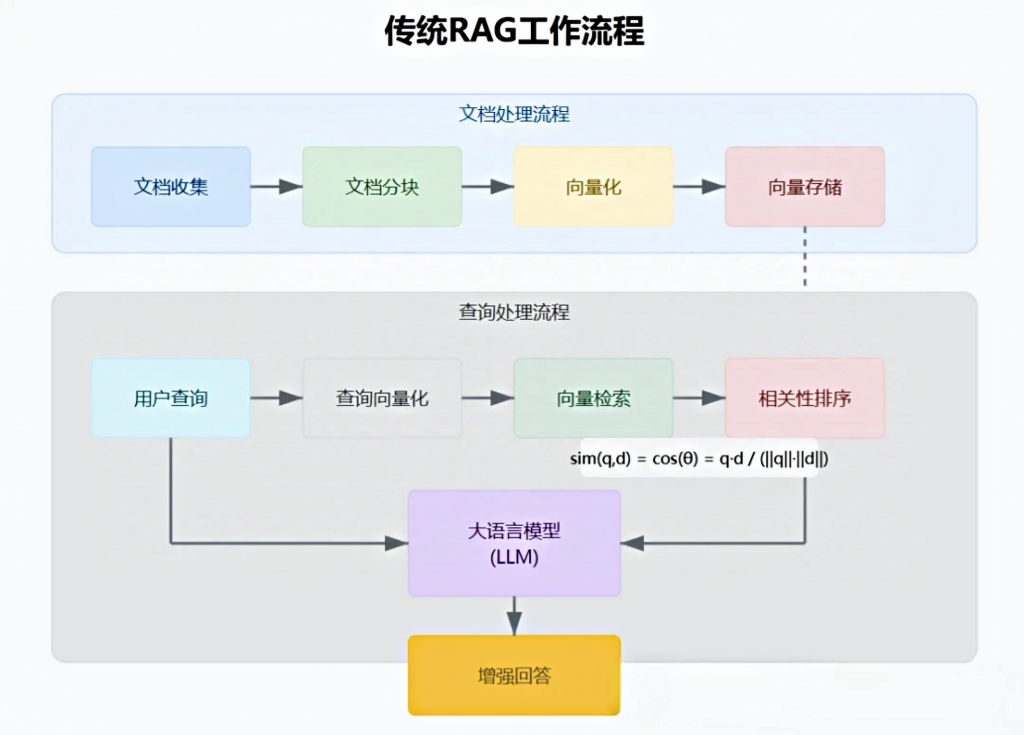

二、RAG架构

RAG架构通常分为三阶段:

结合检索内容与LLM预训练知识,生成连贯且上下文准确的回答。

三、RAG的核心优势

1.减少幻觉(Hallucination):通过检索真实数据约束生成内容,降低模型虚构信息的概率。

2.动态知识扩展:无需重新训练模型即可更新知识库,适应实时场景(如新闻、科技进展)。

3.领域适应性:通过定制知识库,快速应用于医疗、法律、金融等专业领域。

4.可解释性增强:生成结果附带检索来源,方便验证可信度。

四、典型应用场景

1.智能问答系统:回答需结合实时数据的问题(如“2023年诺贝尔奖得主是谁”)。

2.客服机器人:检索产品手册或政策文档,提供精准回复。

3.内容创作辅助:撰写文章时自动补充权威资料或统计数据。

4.教育领域:生成结合教材内容和最新研究的解析答案。

五、ChatWiki:RAG优化的“专家”

ChatWiki 是一款基于大语言模型(LLM)和检索增强生成(RAG)技术的开源知识库 AI 问答系统,支持企业快速构建私有化知识库助手,适用于客服、医疗、教育等场景。

1.多模态知识处理能力

- 支持导入 OFD、Word、Excel、PDF、Markdown 等格式文档,自动完成分块、向量化处理。

- 可整合网页、CSV 等数据源,并通过智能分段优化检索效果。

2.动态知识更新与低幻觉

- 支持实时更新知识库(如最新医疗指南或企业文档),无需重新训练模型。

- 通过检索结果约束生成逻辑,减少大模型虚构内容。

3.Graph RAG 增强推理

- 引入图数据库(Graph Database)技术,利用节点和边的关系提升多跳推理能力(例如通过实体关联链回答复杂问题)。

- 相较于传统 RAG 的孤立文本片段,可返回结构化关联信息,生成逻辑更完整的答案。

4.灵活部署与数据安全

- 支持纯本地私有化部署,保障企业数据隐私。

- 提供 Docker 部署、离线部署等多种方式,适配云端或本地环境46。

5.广泛模型支持与易用性

- 已集成 DeepSeek、OpenAI、Claude、文心一言、火山引擎等 20+ 国内外主流模型,配置简单(仅需配置 API key)。

- 可视化界面支持工作流编排,可组合大模型、工具和业务逻辑节点。开源地址

github地址:https://github.com/zhimaAi/chatwiki

了解更多功能详情,

获取功能试用,请扫码联系

原创文章,作者:小芝麻,如若转载,请注明出处:https://xiaokefu.com.cn/blog/26071.html