传统大模型虽能处理通用问题,却存在两大致命短板:一是知识时效性差,无法同步企业最新业务文档;二是数据安全隐患,涉及敏感信息的提问可能被模型“记忆”并泄露。点此进入芝麻小客服官网

而RAG知识库的出现,恰好解决了这两大痛点。

RAG(Retrieval-Augmented Generation,检索增强生成)结合了信息检索与大型语言模型的双重优势,有效解决了传统AI模型存在的“幻觉问题”和知识滞后等痛点。

与仅依赖预训练数据的传统大模型不同,RAG系统在收到问题时,会首先从企业专属的知识库中检索相关信息,然后将这些精准信息与大模型的强大理解能力相结合,生成既准确又符合上下文的回答。这种“先检索,后生成”的双重保障机制,确保了每一条回答都有据可依,极大提升了信息的可靠度和实用性。

一、国产化RAG解决方案

在数字化转型的关键时期,国产化RAG解决方案不仅关乎技术升级,更是企业数据安全和自主可控的战略保障。选择国产化平台意味着:

- 完全自主的知识产权,避免被国外技术“卡脖子”

- 符合国内数据安全法规,确保敏感信息不出境

- 更好的本地化服务支持,响应迅速、理解深入

- 针对中文场景深度优化,处理中文文档更加精准

以ChatWiki为代表的国产RAG平台,已经实现了从模型对接到知识管理的全链路国产化,为企业提供了安全可靠的智能化升级路径。

二、四步构建智能知识库:从0到1的实战指南

第一步:无缝适配AI大模型

搭建RAG知识库,首要步骤是连接适合企业需求的AI大模型。ChatWiki聚合GPT-4、Claude、DeepSeek、文心一言、火山引擎等20+国内外大模型,支持动态切换或混合调用,平衡成本与效果。

第二步:构建企业专属知识大脑

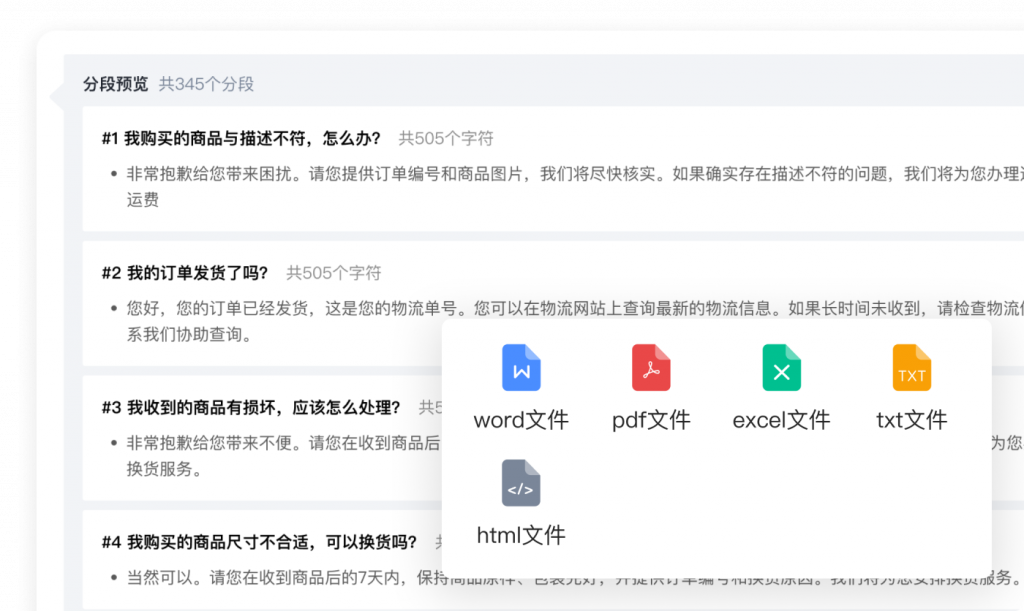

这是知识库搭建的核心环节。在平台上创建知识库后,可批量上传企业各类文档资料,包括ODF、PDF、Word、Excel、PPT等多种格式。关键优势在于系统具备强大的语义理解能力,不仅能识别文字内容,更能理解文档的深层含义,建立跨文档的关联网络。

第三步:打造个性化AI助手

基于已建立的知识库,创建专属的AI机器人。这一步骤中,企业可以定制机器人的回答风格、专业程度甚至个性特点,使其更符合企业的品牌形象和服务需求。通过精确的知识库关联,确保机器人每个回答都基于企业官方资料,避免信息偏差。

第四步:实现智能问答闭环

当客户或员工提出问题时,RAG系统开始发挥其真正的价值。查询过程分为精准检索、智能合成两个关键阶段:首先从知识库中找出最相关的信息片段,然后利用大模型的组织和表达能力,生成自然、流畅且准确的回答。这一过程不仅快速响应了需求,更保证了信息的权威性和一致性。

三、智能知识库的行业应用场景

客户服务领域,RAG知识库能够7×24小时提供准确一致的客服回答,大幅降低人力成本;内部培训方面,新员工可通过智能问答快速掌握岗位知识,培训效率提升显著;专业技术行业,如法律、医疗、工程等领域,专家知识得以完整保存和智能传递;销售团队可随时获取最新的产品信息和竞争分析,提高转化率。

了解更多功能详情,

获取功能试用,请扫码联系

原创文章,作者:小芝麻,如若转载,请注明出处:https://xiaokefu.com.cn/blog/34828.html